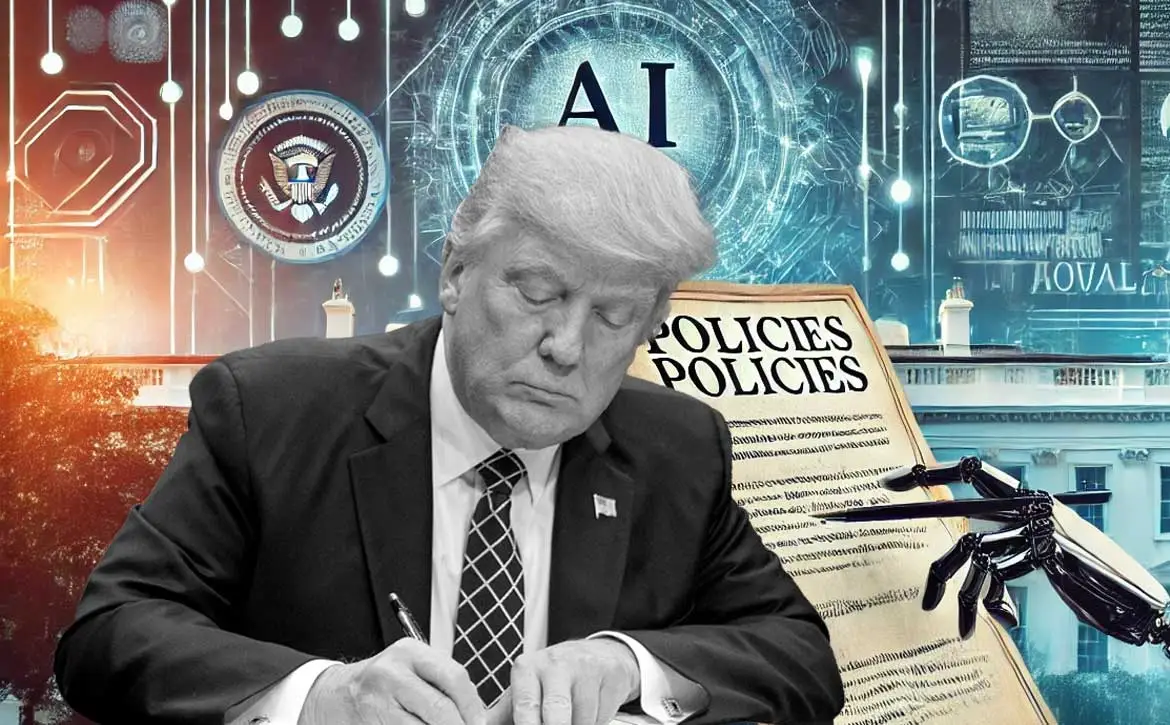

El 21 de enero de 2025, el presidente de Estados Unidos, Donald Trump, tomó una medida significativa al rescindir una orden ejecutiva emitida en 2023 por su predecesor, Joe Biden, que establecía lineamientos clave para garantizar la seguridad en el desarrollo y despliegue de la inteligencia artificial (IA). Esta decisión ha generado un debate profundo sobre el futuro de la regulación de la IA en Estados Unidos y su papel en el panorama global.

La orden ejecutiva de Biden buscaba garantizar que el desarrollo de la IA en el país estuviera alineado con principios de seguridad y ética. Entre sus principales disposiciones se incluía la obligación de los desarrolladores de IA de compartir con el gobierno los resultados de pruebas de seguridad de sus modelos. Además, se encomendó al Instituto Nacional de Estándares y Tecnología (NIST) la elaboración de normas para estas pruebas, mientras que las agencias federales debían evaluar los posibles riesgos de la IA en ámbitos como la seguridad nacional y el empleo.

Con la revocación de estas directrices, Trump argumentó que la regulación excesiva podría sofocar la innovación y limitar la competitividad de Estados Unidos frente a otras potencias tecnológicas como China y la Unión Europea. Además, Trump nombró a David Sacks, un reconocido capitalista de riesgo y exejecutivo de PayPal, como el encargado de liderar los esfuerzos del gobierno en IA y criptomonedas, lo que indica un enfoque más favorable hacia la industria.

La decisión ha sido recibida con opiniones divididas. Algunos sectores de la industria tecnológica celebran la eliminación de restricciones, argumentando que esto permitirá un avance más rápido y menos burocrático en el desarrollo de IA. Sin embargo, expertos y defensores de la ética en tecnología han expresado preocupación por la falta de salvaguardias adecuadas que prevengan riesgos como la discriminación algorítmica, amenazas a la privacidad y potenciales consecuencias no deseadas en el empleo y la seguridad nacional.

Mientras Estados Unidos elimina estas regulaciones, otras regiones avanzan en sus propios marcos normativos. La Unión Europea, por ejemplo, ha implementado la Ley General de Inteligencia Artificial, que clasifica los sistemas de IA en niveles de riesgo y establece obligaciones específicas para cada categoría. Por su parte, China también está desarrollando un enfoque integral para supervisar el impacto de la IA.

La revocación de la orden ejecutiva de seguridad en IA deja a Estados Unidos en una posición de incertidumbre respecto a lma regulación de esta tecnología emergente. Aunque la decisión podría acelerar la innovación, también plantea interrogantes sobre cómo abordará el país los riesgos inherentes a la IA en un contexto global cada vez más regulado.